Derrière la puissance de calcul et la rapidité des systèmes d’intelligence artificielle se cache une réalité souvent négligée : leur consommation énergétique colossale. De la phase d’apprentissage (training) à l’utilisation quotidienne (inférence), l’IA, en particulier l’IA générative, pèse lourdement sur les ressources électriques mondiales, soulevant de sérieuses questions sur son impact environnemental et la nécessité d’une sobriété numérique.

Si l’IA fascine par ses capacités, son coût énergétique est tout sauf abstrait. Une simple requête adressée à un outil comme ChatGPT peut être jusqu’à dix fois plus gourmande en électricité qu’une recherche classique sur Google. Cette consommation ne concerne pas uniquement l’électricité, mais aussi l’eau, utilisée pour le refroidissement des serveurs. Selon des estimations, la formation d’un modèle comme GPT-3 aurait généré l’équivalent de 552 tonnes de carbone et nécessité près de 700 000 litres d’eau.

Ces chiffres donnent le vertige et interrogent sur l’impact de l’adoption massive de ces technologies. Le chercheur Alex de Vries met en garde contre ce phénomène, plaidant pour « la sobriété des usages de l’IA » et soulignant que la phase d’utilisation par le grand public est désormais un facteur majeur de cette explosion énergétique.

Le cœur du problème : les centres de données, moteurs gourmands de l’IA

Les centres de données (data centers) sont le cœur névralgique de l’intelligence artificielle, et leur fonctionnement est particulièrement gourmand en énergie. La consommation électrique de ces installations se divise en plusieurs postes principaux. La majeure partie, soit environ 50%, est consommée par les serveurs qui effectuent les calculs et le stockage de données. L’exécution des algorithmes d’IA, avec leurs millions de paramètres, exige une puissance de calcul phénoménale qui se traduit directement en électricité.

Pour éviter la surchauffe causée par cette intense activité, les systèmes de refroidissement prennent le relais, consommant à eux seuls entre 30 et 40% de l’énergie totale. Enfin, les pertes d’énergie liées à la conversion et à la distribution de l’électricité, ainsi que l’alimentation de l’éclairage et d’autres équipements, représentent les 10 à 20% restants. Selon l’Agence internationale de l’énergie (AIE), la consommation mondiale des centres de données pourrait doubler d’ici 2026, illustrant à quel point ces infrastructures sont énergivores et que leur explosion, en grande partie due à l’IA, a des répercussions directes sur l’énergie à l’échelle mondiale.

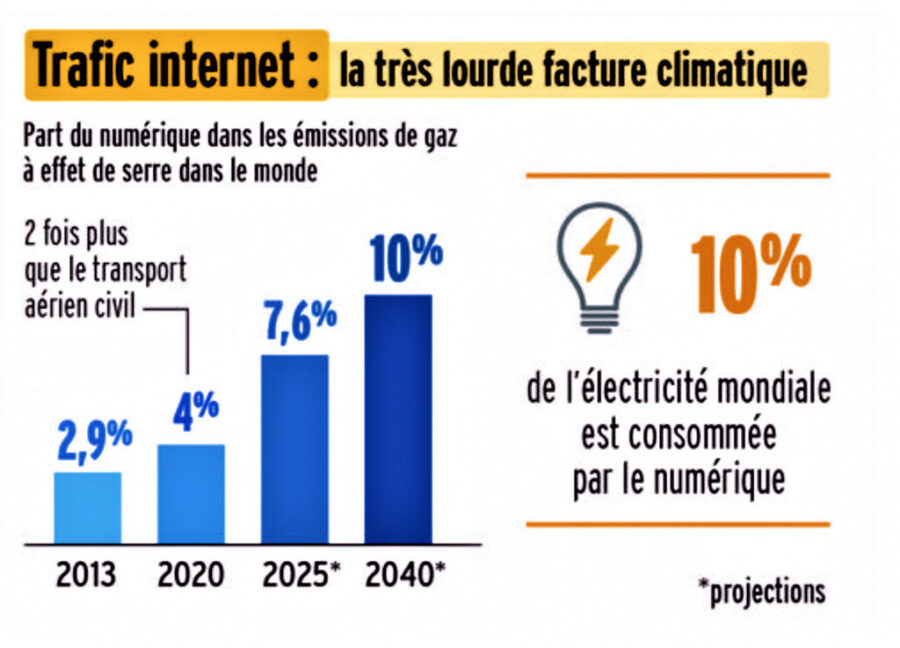

Selon une infographie publiée dans Le Monde, nous constatons que 4% des émissions de gaz à effet de serre dans le monde proviennent du numérique, ce qui représente 2 fois plus que le transport aérien et cette tendance n’est pas prête à s’arrêter. En effet, selon les estimations et les projections ce chiffre devrait presque doubler en 2025 pour atteindre 7,6%.

Dans cette vidéo, Malivina Raud, une journaliste française explique le mécanisme la consommation énergétique de l’IA générative.

Le manque de transparence, un défi de taille

Malgré cette demande énergétique en constante augmentation, la transparence reste un problème majeur. Un rapport de SambaNova révèle que la plupart des entreprises ignorent la consommation énergétique de leurs propres systèmes d’IA. Seulement 13 % d’entre elles surveilleraient cette donnée, ce qui rend difficile toute tentative d’optimisation ou de régulation.

L’essor de l’IA soulève ainsi une question cruciale : si elle promet de résoudre des problèmes complexes, elle crée dans le même temps un défi environnemental d’une ampleur inédite. À l’avenir, la quête de performance devra nécessairement s’accompagner d’une prise de conscience et d’un effort de sobriété, tant du côté des développeurs que des utilisateurs.

Cheikh Tidiane NDIAYE